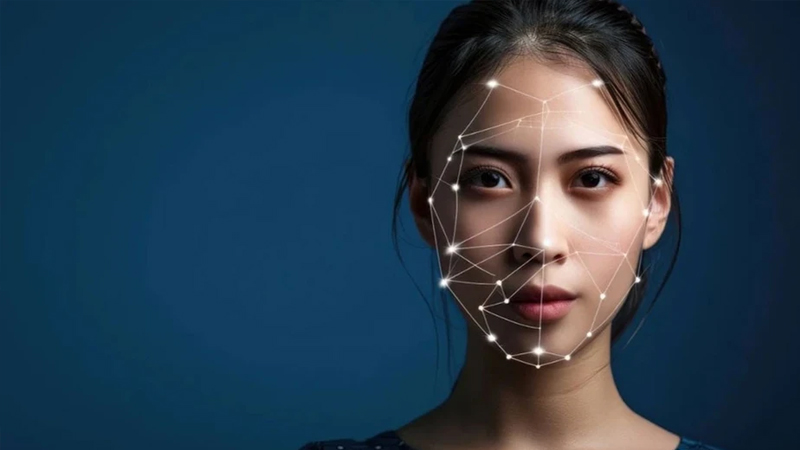

Artıq yalnızca bir şəxsin görüntüsü və səsi deyil, onun nəbzinin atışı və dəri tonundakı dəyişikliklər də süni intellekt tərəfindən yaradılır. Bu inkişaf, saxta (deepfake) videoların müəyyən edilməsini daha da çətinləşdirir.

Valyuta.az xəbər verir ki, son illərdə süni intellekt vasitəsilə hazırlanan "deepfake" videolar yalnız əyləncə deyil, eyni zamanda ciddi bir təhlükəsizlik problemi halına gəlib. Vizual realizm səviyyəsi o qədər inkişaf edib ki, artıq mövzu üzrə mütəxəssislər belə saxta görüntülərlə gerçəyini ayırd etməkdə çətinlik çəkirlər. Texnologiyadakı bu sürətli irəliləyiş, "deepfake" videolarının potensial təhdid kimi daha çox müzakirə olunmasına səbəb olur.

"Deepfake" texnologiyasının çatdığı nöqtə artıq yalnız sosial mediada əyləncə məqsədli filtrlərlə məhdudlaşmır. Dərin öyrənmə alqoritmləri vasitəsilə real şəxslərin mimikaları, üz ifadələri və səs tonları dəqiqliklə təqlid edilə bilir. Bu vəziyyət texnologiyanı niyyətləri pis olan şəxslər üçün son dərəcə təhlükəli bir alətə çevirir.

Siyasi fiqurlar, iş adamları, jurnalistlər və ya ictimaiyyət arasında tanınan şəxslər "deepfake" videolar vasitəsilə asanlıqla nüfuz hücumuna məruz qala bilər, demədikləri sözləri demiş kimi göstərilə və ya etmədikləri cinayətlərə dair saxta sübutlarla qarşı-qarşıya qala bilərlər. Kiber cinayətkar dəstələr və dövlət dəstəkli haker qruplarının bu texnologiyadan təbliğat, manipulyasiya və ya şantaj məqsədilə istifadə etdiyinə dair nümunələr gündən-günə artır.

İstifadəçilər üzlərini yaşlandıran, heyvana çevirən və ya rəqəmsal effektlərlə dəyişdirən sosial media tətbiqlərini əyləncə vasitəsi kimi qəbul etsələr də, bu tətbiqlərin əsasını təşkil edən süni intellekt sistemləri üz cizgilərinizi, mimikalarınızı və danışıq tərzinizi analiz edərək sizi modelləşdirməyi öyrənir. Bu analizlər daha sonra real görünən "deepfake" məzmunlar hazırlamaq üçün istifadə edilə bilər.

Fərdi istifadəçilərdən toplanan bu məlumatlar müxtəlif proqramlarla birləşdirilərək son dərəcə inandırıcı videolara çevrilə bilir. Bu məzmunlar növbəti mərhələdə şantaj, fırıldaqçılıq və ya siyasi manipulyasiya kimi məqsədlərlə istifadə oluna bilər.

"Deepfake" texnologiyasına qarşı hazırlanmış müdafiə üsullarından biri, saxta videolarda nəbz atışının olmaması əsasında qurulmuşdu. Lakin bu üsul da artıq təsirini itirməkdədir. Berlin Humboldt Universitetindən Prof. Dr. Peter Ayzert son açıqlamasında bildirib: "Yeni nəsil "deepfake" videolarında gerçəyə uyğun ürək döyüntüsü ritmi və üz rəngində təbii dəyişikliklər müşahidə edirik. Bu da onların aşkarlanmasını çox daha çətin edir".

Bu inkişaf saxta məzmunların artıq yalnız görüntü və səslə məhdudlaşmayaraq bioloji siqnalları da təqlid edə biləcək səviyyəyə çatdığını göstərir. "Deepfake" hazırlayanlar alqoritmlərini daha da mürəkkəbləşdirərək aşkarlama mexanizmlərini aşmağa çalışırlar.

Gəlinən nöqtədə, internetdə qarşılaşdığımız hər bir videoya şərtsiz şəkildə güvənmək mümkün deyil. "Deepfake" texnologiyasının bu qədər inkişaf etməsi vizual məzmunların doğruluğunu yoxlamağın zəruriliyini ortaya qoyur. Xüsusilə siyasi və ya ictimai baxımdan həssas məzmunlar ehtiva edən videoların mənbəyi və bütövlüyü yoxlanılmadan paylaşılması ciddi nəticələrə səbəb ola bilər.

Nəticə etibarilə, vizual məzmun dövründə yaşayırıq, lakin artıq hər görüntü göründüyü qədər real olmaya bilər. Yeni dövrdə rəqəmsal savadlılıq qədər, görüntü savadlılığı da həyati əhəmiyyət daşıyır.

Paşa Məmmədli